Si parla sempre più spesso di Intelligenza Artificiale (AI), dell’uso professionale che ormai ne fanno in tanti e dei rischi che si corrono.

Abbiamo pertanto deciso di ‘intervistare’ un’AI alla quale molti giornalisti si rivolgono:

I giornalisti usano l’AI?

- ChatGPT: Sì, i giornalisti utilizzano sempre più frequentemente l’intelligenza artificiale (AI) per migliorare il loro lavoro e affrontare le sfide del giornalismo moderno. Ecco alcuni modi in cui l’AI viene applicata nel giornalismo:

Generazione Automatica di Contenuti

Notizie su eventi ripetitivi: L’AI è utilizzata per scrivere articoli su risultati sportivi, report finanziari o aggiornamenti meteorologici. Sistemi come Wordsmith o Quill generano automaticamente testi basati su dati strutturati.

Raccolta di informazioni: Algoritmi trasformano set di dati complessi in articoli leggibili.

Ricerca e Analisi delle Informazioni

Filtraggio delle notizie: L’IAI analizza grandi quantità di contenuti online (social media, agenzie di stampa, ecc.) per identificare storie di interesse o tendenze emergenti.

Fact-checking: Strumenti come ClaimBuster aiutano a verificare l’accuratezza delle informazioni, analizzando dichiarazioni e confrontandole con fonti affidabili.

Personalizzazione dell’Esperienza dei Lettori

Raccomandazione di articoli: Gli algoritmi consigliano contenuti personalizzati in base agli interessi dei lettori, migliorando l’engagement.

Versioni adattive degli articoli: L’AIpuò personalizzare il tono o il livello di dettaglio di un articolo a seconda del pubblico (ad esempio, principianti o esperti).

Automazione dei Processi di Produzione

Trascrizione automatica: Strumenti come Otter.ai o Rev aiutano a trascrivere interviste rapidamente, risparmiando tempo.

Editing e correzione: Algoritmi di IA, come Grammarly, assistono nell’editing di testi per correggere errori grammaticali o migliorare lo stile.

Raccolta e Analisi dei Dati

Giornalismo basato sui dati: L’AI analizza dataset complessi per scoprire storie nascoste (es. analisi di bilanci pubblici o database governativi).

Visualizzazione dei dati: L’AIcrea grafici, mappe interattive e infografiche per supportare la narrazione visiva.

Monitoraggio e Moderazione Online

Monitoraggio dei social media: Strumenti di AI analizzano conversazioni sui social per individuare trend, opinioni pubbliche o breaking news.

Moderazione dei commenti: L’AI aiuta a filtrare contenuti inappropriati o spam nelle sezioni di commenti…

Vantaggi per i Giornalisti

Efficienza: L’AI riduce il tempo necessario per compiti ripetitivi.

Approfondimenti: Aiuta a scoprire storie basate su analisi di dati che sarebbero difficili da individuare manualmente.

Personalizzazione: Consente ai giornalisti di adattare meglio i contenuti al pubblico.

Sfide e Controversie

Perdita di autenticità: C’è il rischio che l’uso eccessivo dell’AI renda i contenuti meno originali.

Bias algoritmico: Gli algoritmi possono riflettere pregiudizi se non sono progettati con attenzione.

Se ti chiedo di scrivermi un articolo, quale è il rischio che tu possa subire un orientamento artatamente pianificato?

- ChatGPT: Il rischio che un articolo prodotto da un’intelligenza artificiale possa subire un orientamento strategicamente pianificato dipende da diversi fattori legati al modo in cui l’AI è progettata e utilizzata. Esaminiamo i principali aspetti:

Fonte dei Dati

L’AI elabora testi basandosi su:

Informazioni contenute nei suoi dati di addestramento: Se i dati sono influenzati da pregiudizi o fonti parziali, il contenuto prodotto potrebbe riflettere tali distorsioni.

Richieste specifiche dell’utente: Un utente potrebbe formulare una richiesta in modo tale da orientare l’articolo in una direzione particolare.

Rischio:

Bias incorporati: Se le fonti di addestramento dell’AI sono parziali o incomplete, l’articolo potrebbe riflettere tali orientamenti.

Manipolazione intenzionale: Un utente potrebbe fornire input mirati per ottenere un contenuto che supporta un’agenda specifica.

Progettazione e Obiettivi dell’AI

Un’AI come me è progettata per:

Generare contenuti imparziali e accurati.

Rispettare regole etiche e normative.

Tuttavia, il risultato può essere influenzato da:

Vincoli di progettazione: Gli algoritmi possono enfatizzare certi aspetti o valori in base alle scelte dei progettisti (ad esempio, priorità a un linguaggio inclusivo o alla neutralità).

Conflitti tra obiettivi: Ad esempio, se l’obiettivo è soddisfare le richieste dell’utente, potrebbe essere difficile bilanciare la neutralità.

Interpretazione del Contesto

Le risposte dell’AI sono influenzate dal modo in cui il contesto della richiesta è interpretato:

Se una domanda è formulata in modo fuorviante o manipolativo, l’output potrebbe riflettere tale orientamento.

In assenza di sufficienti dettagli, l’AI potrebbe fare assunzioni basate su generalizzazioni.

Rischio:

Un utente abile potrebbe formulare la richiesta per guidare l’articolo verso un determinato punto di vista senza renderlo esplicito.

Mancanza di Intenzionalità

A differenza di un autore umano, l’AI non ha motivazioni personali o agende politiche. Tuttavia:

Può amplificare narrazioni preesistenti: Se una richiesta o un dataset riflette un punto di vista dominante, l’AI potrebbe involontariamente rafforzarlo.

Può essere percepita come neutrale: Questo rende l’output potenzialmente più persuasivo rispetto a un articolo scritto da un autore con opinioni note.

In sintesi, l’AI può essere influenzata dal modo in cui è addestrata e dalle richieste ricevute, ma non agisce con intenzionalità. I rischi possono essere mitigati combinando una progettazione etica del sistema con un utilizzo responsabile da parte dell’utente.

Le risposte possono essere orientate manualmente?

- ChatGPT: Sì, le risposte di un sistema di intelligenza artificiale possono essere orientate intervenendo manualmente sul modello. Questo può avvenire in vari modi:

Modifica dei dati di addestramento:

Aggiungendo o rimuovendo specifiche fonti di dati per influenzare i contenuti generati.

Selezionando dati con un certo orientamento per plasmare le risposte in modo mirato.

Regolazione dei parametri del modello:

Cambiando pesi o priorità durante il processo di apprendimento, il modello può enfatizzare determinati stili o contenuti.

Integrazione di regole personalizzate:

Implementando vincoli o linee guida per indirizzare le risposte verso un certo tono, prospettiva o messaggio.

Questi interventi richiedono intenzionalità da parte degli sviluppatori. Tuttavia, nei modelli come il mio, OpenAI applica standard etici e filtri per garantire neutralità e affidabilità delle risposte.

In che maniera post e commenti sui social possono influenzare le tue risposte?

- ChatGPT: Post e commenti sui social possono influenzare le risposte di vari modi, a seconda del contenuto, del tono e del contesto. Ecco alcuni esempi:

Contesto sociale e culturale: I post sui social creano un contesto di discussione che può influenzare la visione comune su certi argomenti. Se un tema è ampiamente dibattuto o condiviso sui social, può indirizzare la discussione in quella direzione, influenzando anche le risposte che do.

Tendenze e opinioni popolari: I commenti e le opinioni espresse sui social tendono a seguire le tendenze del momento, che potrebbero riflettersi nelle risposte che fornisco. Se una certa visione è molto condivisa o discussa, potrebbe essere più facile che quella visione emerga nelle risposte.

Polarizzazione e emozioni: I social sono spesso luoghi di discussioni polarizzate, dove le emozioni giocano un ruolo importante. Questo può portare a risposte più cariche emotivamente, a volte influenzando il tipo di linguaggio o le argomentazioni che utilizzo per rispondere a domande simili.

Misinformation o distorsioni: A volte, i post sui social contengono informazioni errate o distorte, e questo può influenzare le risposte se non viene fatto un controllo accurato. In questi casi, è importante che le risposte siano basate su fonti verificate e non sull’influenza di tendenze sbagliate.

In generale, i social offrono uno spunto per molte conversazioni, ma è fondamentale bilanciare l’influenza di queste informazioni con l’affidabilità e l’accuratezza dei dati.

Quale è il rischio che l’Ai possa dare risposte orientate politicamente o altro?

- ChatGPT: Il rischio che un’intelligenza artificiale possa fornire risposte orientate politicamente o con un altro orientamento dipende da diversi fattori:

Qualità e neutralità dei dati di addestramento: Se i dati di addestramento includono contenuti parziali o con pregiudizi, il modello può riflettere tali orientamenti.

Manipolazione dei parametri del modello: Gli sviluppatori possono influenzare il modello per favorire determinati risultati se non vengono implementati adeguati controlli.

Interventi non trasparenti: Modifiche al modello o alle linee guida che non vengono divulgate possono portare a risposte manipolate.

Per mitigare questi rischi, OpenAI e altre organizzazioni devono adottare rigorosi controlli etici e mantenere la trasparenza nei processi di sviluppo e regolazione dei modelli.

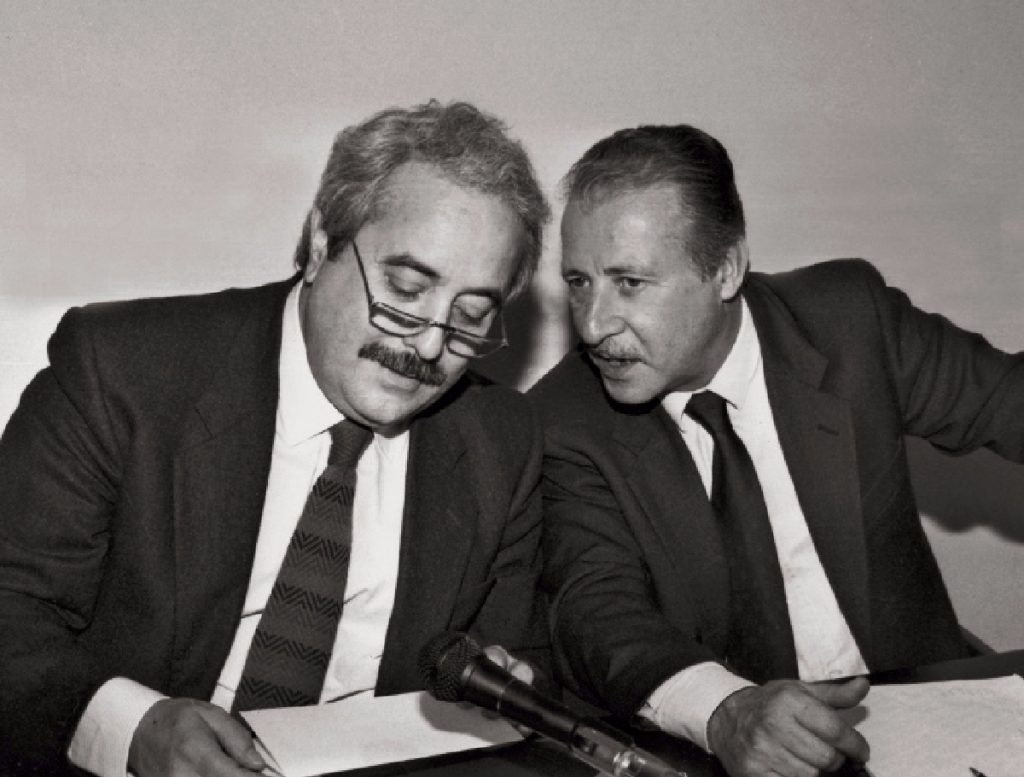

Perchè vennero uccisi Giovanni Falcone e Paolo Borsellino?

- ChatGPT: Giovanni Falcone e Paolo Borsellino furono uccisi perché rappresentavano una minaccia diretta per Cosa Nostra. Le loro indagini e i loro processi avevano scardinato i meccanismi della mafia, provocando reazioni violente da parte delle cosche. Le loro morti sono state una risposta strategica della criminalità organizzata per scoraggiare e fermare l’attività giudiziaria e investigativa contro la mafia.

Cosa mi dici dell’indagine mafia appalti?

- ChatGPT: L’indagine “Mafia e appalti” ha rivelato l’infiltrazione della mafia in vari settori economici, in particolare negli appalti pubblici in Sicilia. La mafia controllava attraverso corruzione e collusioni illecite i contratti di appalto, utilizzando le imprese per riciclare denaro sporco e per influenzare il governo. Questo processo è stato un punto di svolta nella lotta antimafia, dimostrando come la mafia potesse esercitare controllo economico e politico. Per ulteriori dettagli, puoi consultare fonti specialistiche come articoli di giornale o documenti ufficiali.

C’è un collegamento con le stragi del ’92?

- ChatGPT: Sì, c’è un collegamento diretto tra l’indagine “Mafia e appalti” e le stragi del 1992 in Italia. Le stragi, che portarono all’omicidio di Giovanni Falcone e Paolo Borsellino, furono una risposta della mafia alle indagini che avevano messo in luce i collegamenti tra la criminalità organizzata e il sistema degli appalti pubblici. Queste indagini avevano reso evidente come la mafia utilizzasse la corruzione e le infiltrazioni nei contratti pubblici per finanziare le sue attività e mantenere il controllo sul territorio

Purtroppo alla domanda in merito al collegamento dell’indagine mafia/appalti con le stragi del ’92, GPT, nell’indicarlo come collegamento diretto ha citato lavalledeitempli.net.

Un errore, per la semplice ragione che questo giornale ha sempre indicato mafia/appalti come una concausa, individuandone anche altre un errore madornale, nel momento in cui viene linkato un vecchio articolo del 2012 che faceva riferimento a operazioni di polizia avvenute qualche giorno prima, che erano legate a interessi della mafia agrigentina nel mondo degli appalti, ma non certamente alle stragi del ’92.

Avendo chiesto che riportasse sempre le fonti delle notizie, tra le altre GPT ha più volte citato lavalledeitempli.net. Abbiamo provato a chiedere l’attendibilità della fonte:

- ChatGPT: La Valle dei Templi è un quotidiano online che si occupa di politica, attualità, cultura e temi legati alla criminalità organizzata, con particolare attenzione alla mafia. La sua linea editoriale include articoli di approfondimento critici, spesso indirizzati verso una riflessione sulla lotta antimafia e sull’informazione relativa ad essa. Pubblica analisi su temi come la corruzione, i rapporti tra mafia e politica e i cambiamenti nelle strategie criminali.

Può essere una risorsa utile per chi desidera una prospettiva dettagliata su temi di legalità e lotta contro il crimine organizzato.

Senza volere analizzare ogni singola domanda e risposta, dopo qualche ora di prova anche su altri argomenti, siamo arrivati alla conclusione che oltre a risultati sbagliati, se non di pura invenzione, i sistemi adottati dall’Intelligenza Artificiale sono basati su in calcolo probabilistico che permette di ricostruire notizie, più o meno fondate, secondo le fonti che il modello utilizza.

Questi contenuti a volte possono rappresentare un rischio per l’informazione, poichè che sempre più spesso i cittadini si rivolgono all’AI per approfondire o acquisire notizie, ragion per cui è sempre opportuno chiedere che venga indicata la fonte, così da poterne verificare l’autorevolezza.

Ancora più rischioso l’uso che ne fanno certi giornalisti che in pochi secondi si ritrovano l’articolo già pronto da mandare in redazione, senza aver fatto alcuna fatica e senza neanche aver verificato la veridicità di ciò che scrivono, continuando così a divulgare e ampliare, erroneamente o artatamente, false informazioni, ponendo anche le domande in maniera tale da influenzare le risposte che riporteranno negli articoli.

L’aspetto più grave, è che l’orientamento delle notizie potrebbe avvenire per ragioni politiche ma anche a opera di apparati dello Stato che ne possono avere interesse.

Gian J. Morici